Sto registrando ogni visita al mio sito Web e determinare se il visitatore è umano è importante. Ho cercato sul Web e trovato molte idee interessanti su come rilevare se il visitatore è umano.Come rilevare se un visitatore è umano e non un ragno

- se il visitatore è collegato e passò captcha

- rilevano gli eventi del mouse

- Rilevamento se l'utente dispone di un browser [user agent]

- rilevazione clic del mouse [come potrei fare per questo?]

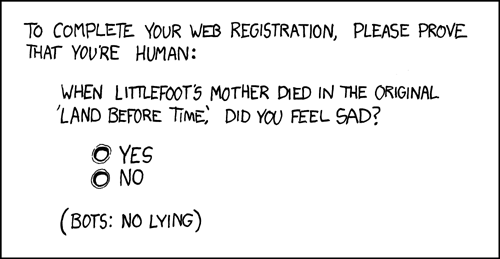

Esistono altri modi infallibili per rilevare se il visitatore è umano?

Chiedilo quante gambe ha. –

Bello, Nick. Adoro l'umorismo ... +1 – pixelbobby

- Merci, amigos! –